Tau nggak, insiden di mana Chatbot Bard AI milik Google telah keliru mengklaim bahwa gambar planet pertama yang terletak di luar tata surya kita ditangkap oleh Teleskop Luar Angkasa James Webb?

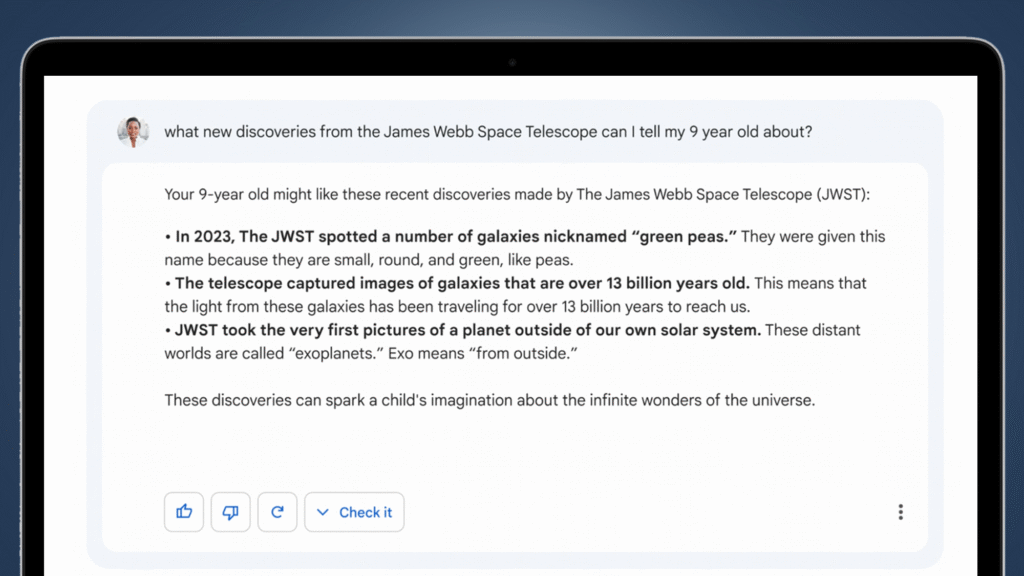

Melalui sebuah gambar yang dibagikan oleh Google di platform X, terlihat Bard menjawab pertanyaan terkait penemuan baru dari Teleskop Luar Angkasa James Webb dengan tiga poin, satu di antaranya menyatakan bahwa teleskop tersebut mengambil gambar pertama sebuah planet di luar tata surya kita. Pada kenyataannya pernyataan tersebut tidak benar, mengutip pada website NASA bahwa gambar pertama planet di luar tata surya kita diambil pada tahun 2004 dengan VLT (Very Large Telescope), tidak seperti jawaban yang telah diberikan oleh Bard AI.

Fenomena tersebut di mana AI memberikan informasi palsu tetapi meyakinkan, dikenal dengan istilah ‘halusinasi AI’ yang dapat terjadi pada generatif AI. Istilah ini benar adanya, bahwa tidak hanya manusia yang dapat mengalami halusinasi, akan tetapi juga dapat terjadi pada mesin.

Istilah ‘halusinasi’ digunakan untuk menggambarkan perilaku irrasional yang dihasilkan oleh sistem kecerdasan buatan. Akan tetapi, definisi halusinasi AI itu sendiri belum terdapat definisi yang baku karena terdapat banyak perbedaan pendapat di antara para sarjana yang meneliti. Pada dasarnya, halusinasi AI merujuk pada fenomena ketika generatif AI memberikan informasi yang terdistorsi (informasi palsu atau tidak akurat terlepas dari kesengajaan penulisan) terhadap suatu pertanyaan. Generatif AI dapat membuat informasi yang salah tersebut jadi terlihat meyakinkan.

Some scholars define AI hallucination as “instances where an AI chatbot generates fictional, erroneous, or unsubstantiated information in response to queries” (Kumar et al. 2023). Moreover, a study posited that within the domain of large language models (LLMs), “hallucination” can be categorized into three distinct types: “Input-conflicting hallucination”; “Context-conflicting hallucination”; and “Fact-conflicting hallucination” (Liu et al. 2024). Alternatively, some scholars advocate for the term “AI fabrication” as a replacement for “AI hallucination” to denote instances where AI systems generate false information (Christensen 2024).

Di satu sisi, penggunaan AI tentu diikuti dengan keinginan untuk mendapatkan respon yang relevan dengan pertanyaan yang diajukan . Tetapi di sisi lain, algoritma AI dapat memberi jawaban yang tidak berdasar pada data pelatihan, kesalahan interpretasi transformator, atau kegagalan mengikuti pola yang dapat dikenali, di mana situasi inilah ketika AI berhalusinasi terhadap respon.

Kenapa Generatif AI-pun Dapat Berhalusinasi?

Secara sederhana, fenomena ini dapat terjadi karena pengenalan yang tidak akurat terhadap citra dan pola. Generatif AI melihat pola atau objek yang tidak ada atau tidak terlihat oleh pengamat manusia, menciptakan output yang tidak masuk akal atau sama sekali tidak akurat.

Mekanisme di balik generatif AI atau kecerdasan buatan, adalah sejumlah besar bahasa manusia yang digunakan sebagai data untuk melatih algoritmanya agar dapat secara akurat dapat memberikan respon. Generatif AI akan memperlajari hubungan statistik antara berbagai kata dan kelompok katanya. Akan tetapi, terkadang AI cenderung “menghafal” detail spesifik dari data pelatihan daripada mempelajari pola umum yang sesungguhnya (overfitting). Saat menghadapi input baru yang tidak persis sama dengan data pelatihan, model akan “mengisi kekosongan” dengan cara yang tidak logis berdasarkan detail yang dihafal. Selain overfitting, halusinasi AI juga dapat terjadi karena bias data pelatihan, kompleksitas model yang tinggi.

Pendahulu ChatGPT 4 — ChatGPT 3 dan 3.5 — diketahui telah menggunakan “ratusan miliar kata.” Copilot didasarkan pada ChatGPT 4, yang menggunakan korpus lebih besar daripada ChatGPT 3 atau 3.5. Meskipun kita tidak tahu persis berapa banyak kata yang digunakan, lompatan antar versi ChatGPT cenderung berlipat ganda. Korpusnya juga mencakup buku, jurnal akademik, dan artikel berita. (ChatGTP and the Generative AI Hallucinations, Medium, 15 Maret 2023.)

Fenomena yang mungkin terjadi ini telah menimbulkan kekhawatiran atas kebenaran informasi yang dihasilkan oleh generatif AI. Mengetahui kemungkinan bahwa generatif AI dapat berhalusinasi dalam memberikan respon, maka kita sebagai pengguna perlu untuk berhati-hati ketika menggunakan sistem AI tersebut. (Huang 2023).

Apakah Halusinasi AI Dapat Dihilangkan?

Lalu apakah kita dapat menghilangkan halusinasi pada generatif AI ini? Sayangnya, sulit unutk memperbaiki fenomena ini secara permanen karena generatif AI itu sendiri dibuat di atas dataset yang sangat besar dan untuk dapat menghilangkan halusinasi AI terhadap suatu topik tertentu, setiap artikel, kalimat, dan kata dalam korpus yang terkait dengan topik tersebut harus diperiksa untuk mengidentifikasi dan menghapus bahasa yang bias. Dengan dataset yang sangat besar, tentu hal tersebut sulit untuk dilakukan.

Maka sebagai tindakan untuk mencegah terjadinya penyebaran informasi yang salah, penting untuk kembali mengonfirmasi jawaban yang diberikan oleh AI kepada sumber yang terpercaya. Hal ini dilakukan untuk memastikan bahwa informasi yang diterima benar, akurat, dan dapat dipertanggungjawabkan. Meskipun generatif AI mampu memberikan jawaban dengan cepat, tidak menutup kemungkinan sistem tersebut melakukan kesalahan dan memberikan informasi yang tidak sepenuhnya tepat. Dengan melakukan pengecekan ulang pada sumber resmi atau sumber kredibel, kita dapat menghindari kesalahpahaman, berita palsu, serta dampak negatif yang mungkin timbul akibat penyebaran informasi yang keliru.

0 Komentar